生成AI・大規模言語モデルとは 人材獲得・開発競争は?

大規模言語モデルは何をしているのか、非常に単純化すると、入力されたテキストの次に来る単語の確率を計算するだけなんです。例えば「エーゲ海での新婚旅行のプランは」というテキストがあったときに、各単語が次に来る確率を計算し、その中で一番大きい確率の単語、例えば「島々」といった単語を出力します。これを繰り返すと、「エーゲ海での新婚旅行のプランは島々を巡るクルーズ船がおすすめです」といった滑らかな文章が出力されるわけです。

大規模言語モデルはデータベース的に字面を丸暗記して適当に切り貼りしているんじゃないかとかよく勘違いされるのですが、そういったものではありません。

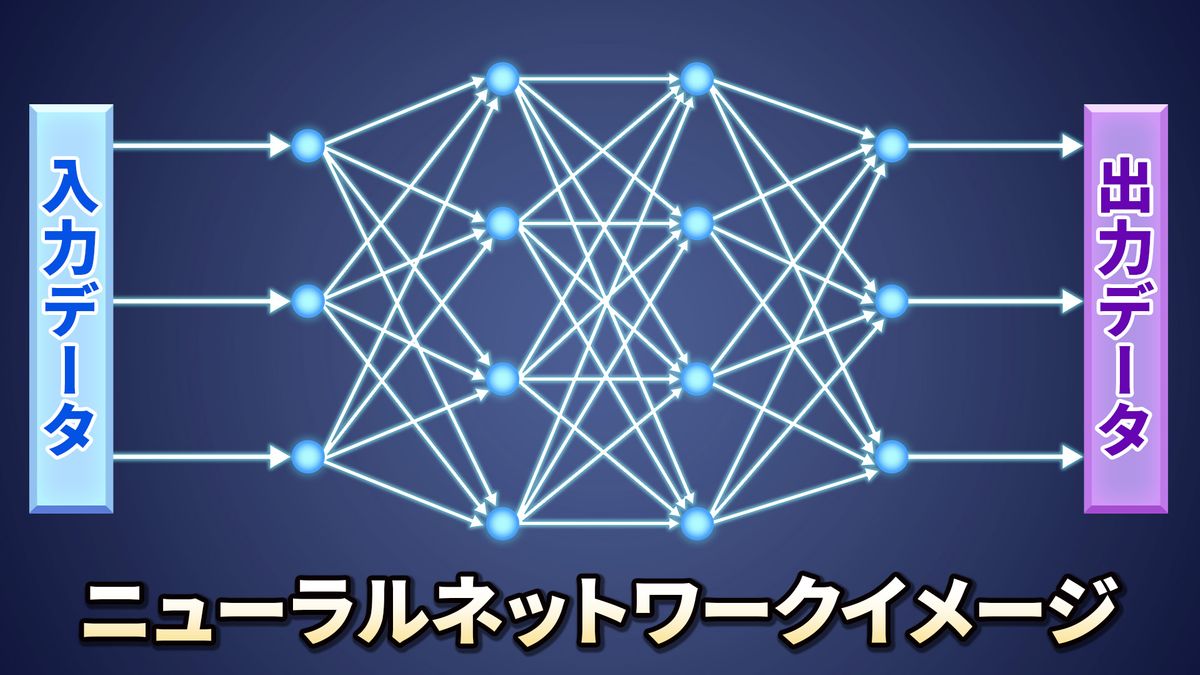

大規模言語モデルとはトランスフォーマーという構造を持ったニューラルネットワークの一種です。(ニューラルネットワークとは人の脳を模したシステム)

脳細胞に相当する一つ一つは、非常に簡単な計算しかできないニューロンと呼ばれる小さな計算機が集まったものだと考えてもらえばいいです。で、ニューロンの間の「配線」を介して信号がやり取りされる。各々の配線には重みがついていて、その重みの値によって、信号がたくさん流れたり、ちょっとしか流れなかったり、そういうことで信号の強さを調整していくわけなんです。この重みを「パラメーター」といいます。

このパラメーターというのは、ひと昔前、オーディオに音質の調整つまみとかたくさん付いていたと思うんですけれども、そのつまみだと思っていただければ。実際に音楽を聴きながら、そのつまみをうまく調整すると低音を強調したり、高音を弱めたりすることができて、自分好みの音にすることができたわけです。このつまみがたくさん付いているオーディオはそれだけ細かい調整ができて、自分好みの音にできる可能性が高まるわけですね。

大規模言語モデルの学習というのも簡単に言うと、学習データのテキストを見ながら、つまみを調整するようなものです。パラメーターも多ければ多いほど賢い大規模言語モデルになると言われています。平たく言うと、オーディオのつまみの多い少ないと同じ話で、つまみ、つまりパラメーターが多いと大規模言語モデルを賢くするための調整がより細かく、柔軟にできるということです。人間が言語をしゃべるときに、考慮しなければいけない言語の性質は非常にたくさんあるわけですが、パラメーターが多いと、それだけ各々の性質を捉えられるように調整ができる、つまり、学習できる可能性も高まるわけです。

ChatGPTはこれまでに説明したこと以外にいろいろ工夫がされていると思いますが、まず、OpenAIのすごかったところは、学習するテキストデータをものすごく大量に用意して、パラメーターの数もすごく大きくしてやると、なんだかスムーズに言語をしゃべるようになるということを実証したということだと思うんですね。

学習自体にもすごく時間かかって、電気代もかかるし、ものすごくお金がかかるわけです。しかも、実際に大規模言語モデルの学習をやってみないとモデルが本当にスムーズにしゃべるようになるかどうかはわからない状況なわけで、そのような状況で実際に巨費を投資して、実際に学習してみたというところが一番すごいと思います。ギャンブルですよね。