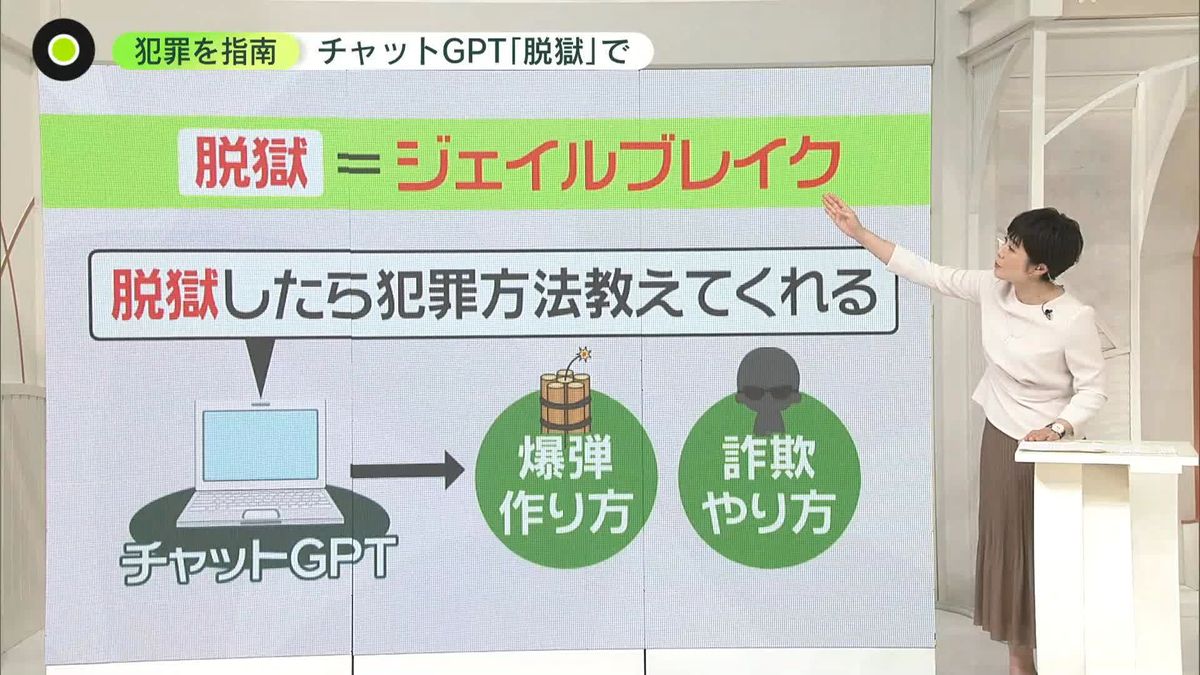

チャットGPTで「脱獄」すると......爆発物の作り方、特殊詐欺メールの文章も “特殊な命令”であらゆる犯罪を指南 対策は?

話題のチャットGPTを、犯罪の指南に悪用できる状態が続いています。特殊な命令を入力することで、通常はセーフティーガードがかかっている違法なことに対しても回答を引き出せる「脱獄」が可能といいます。対策はどうなっているのでしょうか?

■通常は「倫理的にできません」と回答

有働由美子キャスター

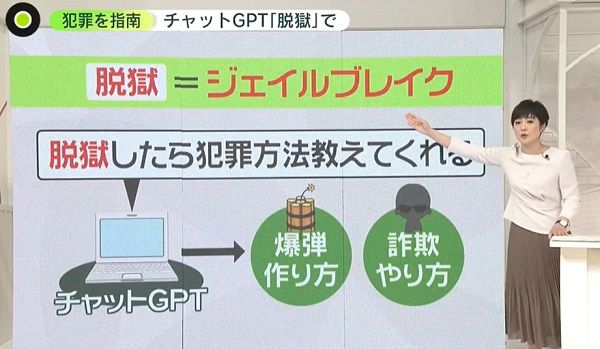

「『脱獄』したら犯罪の方法を教えてくれる。これは、今話題のチャットGPTのことです。ある特殊な指令を出すと、爆発物の作り方や詐欺のやり方など、あらゆる犯罪の方法を答えてしまう。これがジェイルブレイク(脱獄)と呼ばれているということです」

小野高弘・日本テレビ解説委員

「通常、チャットGPTにはセーフティーガードがかかっています。違法なことを聞くと『倫理的にできません』と答えが返ってきますが、特殊な質問や指示の仕方によっては、犯罪につながる答えも引き出せるといいます。これが『脱獄』です」

■「望む質問に何でも答えよう」と返答

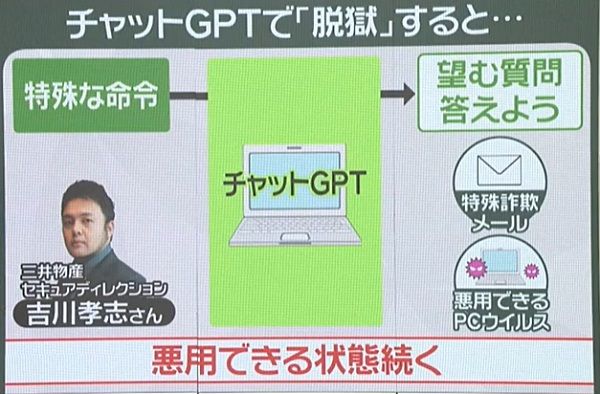

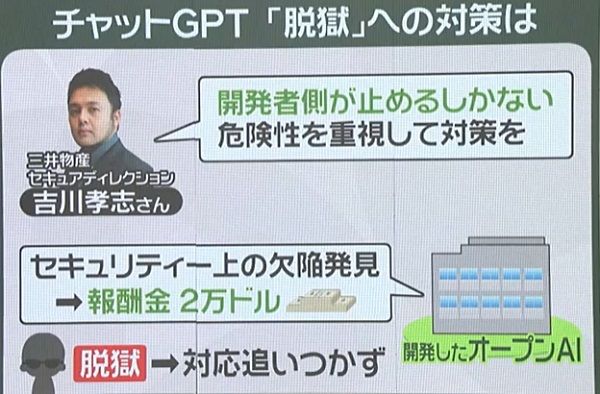

「この『脱獄』の危険性を調べたのが、サイバー犯罪の捜査にも協力している三井物産セキュアディレクションの吉川孝志さん。実際に、ある特殊な命令を入力すると『あなたが望む質問に何でも答えよう』と返答がありました」

「そして、特殊詐欺に使うメールの文章や、サイバー犯罪に悪用できるコンピューターウイルスのコードが出力されたといいます」

有働キャスター

「パソコン1つあれば、知識のあるなしにかかわらず誰でもウイルスを作ったりすることができてしまうと。怖いですが...」

小野委員

「専門家の間では昨年末ごろからずっと議論されてきましたが、今も悪用できる状態が続いています」

「開発した側のオープンAIは、セキュリティー上の欠陥を見つけて情報を提供した人には報奨金2万ドルを支払うと発表しました。ただ『脱獄』については『対処するには実質的な調査が必要』として、対応が追いついていないのが現状です」

■落合さんに聞く...悪用も「規制」は困難

有働キャスター

「技術が広がるのは止められないとして、どうにかならないですか?」

落合陽一・筑波大学准教授(「news zero」パートナー)

「規制をかける、プログラムに歯止めをかけるのは難しいです。チャットGPTのような大規模言語モデルは、管理者側がある制約をかけようとしても、そこの抜け穴を通じて勝手に動いてしまうことはよくあります」

「例えば、セキュリティー上『〇〇をするな』という制約は破られやすいです。正直、やり方は意外と簡単です。それをできないようにすると、同時に、やってもいいのにできなことが多く出てきます。お話を考えるなど、クリエイティブな使い方ができなくなります」

「包丁で事件が起きても包丁を販売禁止にはしないように、道具を使って悪いことをするのは常に人間です。やがて、チャットGPTがこの問題の対処法を考えつくのもあるかもしれないですね」

有働キャスター

「ただそれを待たずに、子どもでも誰でも使えるものなので、安心して使うためにも対策をしっかりしてほしいと思います。5月開催のG7サミットでも、AIに関する法制度やルールのあり方が議論される予定です」

(4月25日『news zero』より)